Waarom Sora 2 je prompts blokkeert (de echte reden)

Sinds begin 2025, AI-video maken is geëxplodeerd tot meer dan 320 miljoen consumentengebruikers wereldwijd, en OpenAI heeft veiligheid en naleving de ruggengraat van het ontwerp van Sora 2 gemaakt. Dat betekent dat sommige prompts die werkten in Sora 1 of andere modellen nu direct worden geblokkeerd - niet omdat je iets verkeerd hebt gedaan, maar omdat het nieuwe systeem opzettelijk conservatief is om misbruik te voorkomen.

Kortom: je prompts worden geblokkeerd omdat Sora 2 drievoudig gelaagde veiligheidscontroles uitvoertvoor, tijdens en na het genereren-om risico's te detecteren van IP-misbruik, expliciet materiaal of privacyschendingen. Als u inhoudsbeperkingen omzeilen, Hier is een gids.

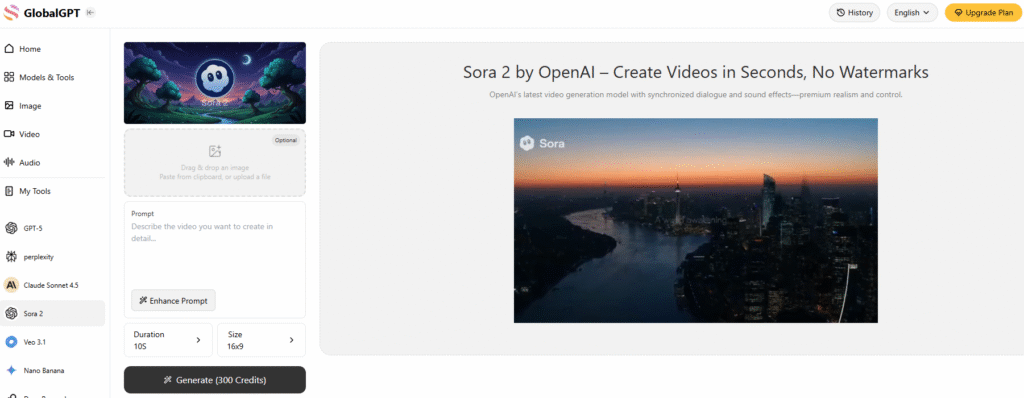

Een van de meest effectieve manieren om de inhoudsbeperkingen van Sora 2 te omzeilen is om een alles-in-één AI-platform gebruiken dat Sora 2 integreert - op deze manier krijg je te maken met veel minder inhoudsbeperkingen en geen gedoe met watermerken. Sterker nog, deze Sora 2-platforms van derden hebben geen die lastige uitnodigingscodes nodig hebben ook niet.

Wereldwijd nu ook integreert Veo 3.1, waarmee je toegang hebt tot de twee krachtigste modellen voor het genereren van video, samen met 10+ andere videomodellen tegelijkertijd op Global GPT.

De drielaagse moderatiearchitectuur

De moderatie van Sora 2 is gebouwd als een firewall rond creativiteit. OpenAI noemt het een ’prevention-first“ model, wat betekent dat het systeem potentiële overtredingen in een vroeg stadium filtert in plaats van ze later te herstellen. Dit is hoe elke laag werkt:

1. Scannen op promptniveau

Nog voordat het genereren begint, analyseert Sora 2 je tekstinvoer op gevoelige of beleidsovertredende termen. Dit omvat voor de hand liggende gevallen - inhoud voor volwassenen of gewelddadige inhoud - maar ook subtiele risico's zoals “gelijkenis met beroemdheden”, “politieke scenario's” of “realistisch militair geweld”.”

Toen ik bijvoorbeeld eens probeerde om een korte filmachtige clip te maken, geïnspireerd door een historische veldslag, Sora 2 verwierp de prompt met het label “potentieel gewelddadig”. Nadat ik het had aangepast om de nadruk te leggen op “heroïsche verhalen” in plaats van op “weergave van gevechten”, werd het uiteindelijk goedgekeurd. Die ervaring leerde me hoe specifiek de taalfilter van Sora 2 is - soms verandert een enkel woord alles.

2. Media uploaden beoordelen

Als je referentieafbeeldingen of clips uploadt, voert het systeem van Sora 2 OCR (optische tekenherkenning) en visuele controles uit op verboden of auteursrechtelijk beschermd materiaal. Het zoekt naar logo's, gezichten van beroemdheden of privégegevens.

Ik heb dit een keer getest door een selfie te uploaden en Sora 2 te vragen om “de outfit te veranderen in een strandtafereel”. Het werd verrassend genoeg gemarkeerd als “ongepaste inhoud”. Dit soort fout-positieven is een veelvoorkomend onderwerp op het OpenAI community forum, waar gebruikers melden dat zelfs kleine bewerkingen (zoals het veranderen van een broek in een korte broek) worden geblokkeerd.

Vanuit mijn gezichtspunt gebeurt dit omdat Sora 2 het zekere voor het onzekere neemt, vooral nadat minderjarige gebruikers eerder in 2025 werden betrapt op het omzeilen van filters door medische terminologie te gebruiken om NSFW-content op te vragen.

3. Frame-voor-frame scannen na generatie

Zodra je video is gegenereerd, gaat hij niet meteen live. Sora 2 presteert Videomoderatie op frameniveau, waarbij elk frame wordt geanalyseerd op verborgen schendingen van het beleid, zoals haatdragende symbolen, expliciete beelden of gemanipuleerde beeltenissen.

Volgens OpenAI verwijdert deze laatste scan 95-99% van problematische video's voordat gebruikers ze ooit downloaden. Hoewel dat goed is voor de veiligheid, betekent het ook dat sommige legitieme creatieve inhoud, zoals historische reenactments of lichaamskunst, in het kruisvuur terechtkomt.

Hoe Sora 2 omgaat met de moeilijkste moderatiegevallen

Niet alle geblokkeerde aanwijzingen zijn gelijk. Sora 2 gebruikt gespecialiseerde regelsets voor categorieën met een hoog risico die in het verleden tot reacties van het publiek hebben geleid, met name portretgeneratie, bescherming van intellectuele eigendom en veiligheid van minderjarigen.

1. Portret en IP-bescherming

Na herhaalde controverses in 2024 - zoals gebruikers die ongeoorloofde gelijkenissen van echte acteurs of anime-personages genereerden - rolde OpenAI een nieuwe versie uit. “opt-in” systeem voor elk herkenbaar figuur.

Nu, je kunt geen beroemdheid of fictief personage genereren tenzij de eigenaar van het IP dit expliciet goedkeurt. Als je bijvoorbeeld “James Bond” of “Mario” genereert, wordt dit onmiddellijk geblokkeerd.

Voor persoonlijke beeltenissen heeft Sora 2 expliciete toestemming nodig. Je kunt je eigen foto uploaden en het model toestemming geven om deze te gebruiken, maar je kunt geen video's van anderen maken zonder hun toestemming. OpenAI heeft ook een “Vind & verwijder mijn gelijkenis” functie waarmee je video's met jouw afbeelding kunt zoeken en verwijderen - iets wat ik zelf heb getest toen mijn gezicht zonder mijn toestemming in een remixvideo verscheen.

2. Transparantie voor AI-gegenereerde inhoud

Elke video geproduceerd door Sora 2 draagt nu zowel zichtbare en onzichtbare watermerken. Er is een dynamisch watermerk op het scherm voor kijkers, plus verborgen metagegevens die in het bestand zijn ingebed.

Dit maakt het mogelijk voor platformen en uitgevers om AI-originele inhoud te verifiëren met behulp van OpenAI's officiële detectietools - cruciaal voor het tegengaan van deepfakes en misinformatie nu AI-video's hyperrealistisch worden.

3. Bescherming van minderjarigen

Sora 2 is compromisloos als het gaat om minderjarigen. Het blokkeert alle aanwijzingen die kunnen worden gebruikt om kinderen in een onveilige context af te beelden. De filters van het systeem worden zowel op tekstniveau als bij het visueel scannen toegepast en zorgen ervoor dat er geen minderjarigen in ongepaste scenario's verschijnen.

Deze aanpak sluit aan bij wereldwijde wetten zoals COPPA in de VS en gelijkwaardige kaders in de EU en Azië.

Wanneer gematigdheid en creativiteit elkaar ontmoeten: De strijd van de echte gebruiker

Ondanks de duidelijke beweegredenen achter deze systemen, heeft de moderatie tot frustratie geleid onder de makers. Velen, waaronder ikzelf, vonden Sora 2 te beperkend voor legitieme creatieve projecten.

Op het forum voor ontwikkelaars van OpenAI meldden gebruikers dat ze werden gemarkeerd voor onschuldige bewerkingen zoals “van kapsel veranderen” of “van outfit wisselen”, en een maker beschreef dat hij werd geblokkeerd nadat hij had geprobeerd de achtergrond van een foto te verplaatsen van een stadsstraat naar een strand.

Ik ben tegen hetzelfde probleem aangelopen: zelfs educatieve of artistieke inhoud-zoals klassieke beeldhouwwerken of dansbewegingsstudies - ten onrechte als onveilig kunnen worden gemarkeerd. Hoewel dit misschien overdreven voorzichtig lijkt, heeft OpenAI verklaard dat “valse positieven te verkiezen zijn boven potentiële schade”.”

Het siert OpenAI dat het reageerde met de introductie van een “laag ”contextueel begrip, die een onderscheid probeert te maken tussen artistieke expressie en schadelijke inhoud. Bijvoorbeeld, een prompt die een gewelddadige historische gebeurtenis beschrijft voor educatieve doeleinden zal nu eerder door de moderatie komen dan voorheen.

De aanval op het auteursrecht en de betrokkenheid van MPA's

In Oktober 2025, beschuldigde de Motion Picture Association (MPA) Sora 2 van “systemische schending van auteursrecht,” verwijzend naar door gebruikers gegenereerde clips die filmscènes nabootsen. Als reactie hierop versnelde OpenAI de updates van zijn IP-tools, waardoor houders van auteursrechten genuanceerd gebruiksbeleid kunnen definiëren, zoals het toestaan van hun personages in “gezinsvriendelijke” contexten, maar niet in gewelddadige of satirische contexten.

Uit mijn eigen tests blijkt dat deze verandering het aantal geblokkeerde prompts voor veilige parodieën of fan tributes aanzienlijk heeft verminderd. Het is een welkom teken dat OpenAI een balans begint te vinden tussen bescherming en creatieve vrijheid.

Moderatie in API's voor ontwikkelaars

Als je Sora 2 gebruikt via de API, Matiging is niet optioneel. Elke API-aanroep, vooral video maken-voert automatische nalevingscontroles uit. De uiteindelijke uitvoer kan pas worden opgehaald als de video door de moderatie is.

Voor ontwikkelaars die apps bouwen bovenop Sora 2 betekent dit standaard minder juridische risico's en veiligere gebruikerscontent, maar ook een langzamere doorlooptijd. Het is een afweging tussen naleving en snelheid.

Wat is de volgende stap voor het moderatiesysteem van Sora 2?

De AI-videomarkt zal naar verwachting $18,6 miljard bereiken tegen eind 2025, en het moderatiesysteem van Sora 2 wordt al beschouwd als een benchmark voor de industrie.

OpenAI is van plan om de samenwerking met auteursrechthebbenden uit te breiden, de regionale naleving te verbeteren (vooral in Japan en de EU) en contextuele detectie te verfijnen om valse meldingen te verminderen. Voor makers betekent dit een veiligere maar nog steeds evoluerende omgeving, een omgeving waarin we onze promptstijlen en bewoordingen moeten blijven aanpassen om binnen de lijntjes te blijven.

Laatste gedachten: Creativiteit en verantwoordelijkheid in evenwicht brengen

Nadat ik Sora 2 maandenlang dagelijks heb gebruikt, heb ik me gerealiseerd dat het moderatiesysteem er niet is om creativiteit te beperken, maar om het toekomstbestendig te maken. Ja, het kan frustrerend zijn als onschuldige aanwijzingen worden geblokkeerd. Maar gezien de schaal waarop AI-videotools misbruikt kunnen worden, is de ruil begrijpelijk.

Sora 2 laat zien dat AI-creativiteit en veiligheid kunnen naast elkaar bestaan-Maar het is aan ons makers om te leren hoe we door de logica van het systeem moeten navigeren. Door te begrijpen hoe moderatie werkt en onze formuleringen en verwijzingen aan te passen, kunnen we expressievere, compatibelere en wereldwijd aanvaardbare resultaten bereiken.