Perché Sora 2 blocca i tuoi suggerimenti (il vero motivo)

Dall'inizio del 2025, Creazione di video AI è esploso a oltre 320 milioni di utenti consumer a livello globale, OpenAI ha fatto della sicurezza e della conformità la spina dorsale del progetto di Sora 2. Ciò significa che alcune richieste che funzionavano in Sora 1 o in altri modelli ora vengono bloccate all'istante, non perché si sia fatto qualcosa di sbagliato, ma perché il nuovo sistema è intenzionalmente conservativo per evitare usi impropri.

In breve: le vostre richieste sono bloccate perché Sora 2 esegue controlli di sicurezza a triplo livello-prima, durante e dopo la generazione, per rilevare i rischi legati all'uso improprio dell'IP, al materiale esplicito o alle violazioni della privacy. Se volete aggirare le restrizioni sui contenuti, Ecco una guida.

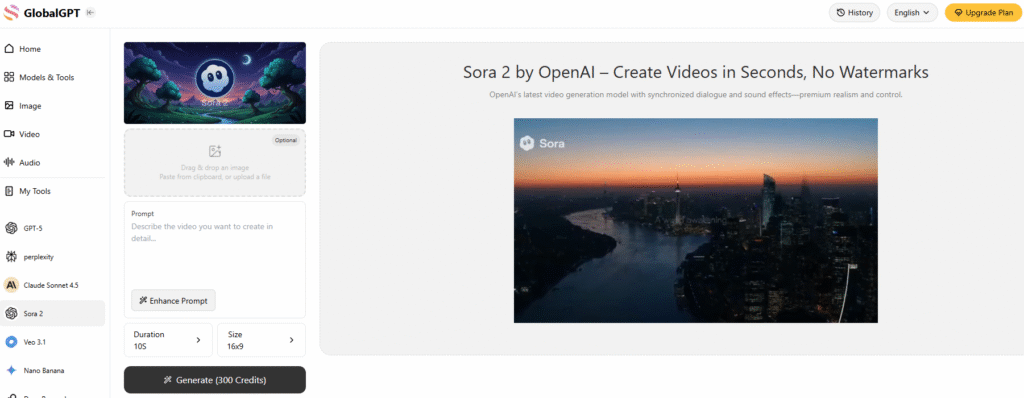

Uno dei modi più efficaci per aggirare le restrizioni sui contenuti di Sora 2 è quello di utilizzare una piattaforma AI All-in-One che integra Sora 2 - in questo modo, vi troverete di fronte a un numero molto minore di restrizioni di contenuto e di Nessun problema di filigrana. Ancora meglio, queste piattaforme di terze parti per Sora 2 non richiedere quei fastidiosi codici di invito o.

Ora anche globale integra Veo 3.1, che consente di accedere ai due modelli di generazione video più potenti insieme a 10+ altri modelli video contemporaneamente su Global GPT.

L'architettura di moderazione a tre livelli

La moderazione di Sora 2 è costruita come un firewall intorno alla creatività. OpenAI lo definisce un modello ’prevention-first“, ovvero il sistema filtra le potenziali violazioni in anticipo invece di correggerle in un secondo momento. Ecco come funziona ogni livello:

1. Scansione a livello di prompt

Prima ancora di avviare la generazione, Sora 2 analizza il testo immesso alla ricerca di termini sensibili o che violano le norme. Questo include casi ovvi - contenuti per adulti o violenti - ma anche rischi sottili come “somiglianza con celebrità”, “scenari politici” o “violenza militare realistica”.”

Per esempio, quando una volta ho cercato di creare un breve clip in stile cinematografico ispirato a una battaglia storica, Sora 2 ha rifiutato la richiesta, definendola “potenzialmente violenta”. Dopo averlo modificato per concentrarsi sulla “narrazione eroica” invece che sulla “rappresentazione di battaglie”, alla fine è passato. Questa esperienza mi ha insegnato quanto sia specifico il filtro linguistico di Sora 2: a volte una sola parola cambia tutto.

2. Revisione del caricamento dei media

Se si caricano immagini o clip di riferimento, il sistema di Sora 2 esegue controlli OCR (riconoscimento ottico dei caratteri) e visivi per individuare materiale vietato o protetto da copyright. Cerca loghi, volti di celebrità o dettagli privati.

L'ho provato una volta caricando un selfie e chiedendo a Sora 2 di “cambiare l'outfit in una scena da spiaggia”. Sorprendentemente è stato segnalato come “contenuto inappropriato”. Questo tipo di falsi positivi è stato un argomento frequente sul forum della comunità di OpenAI, dove gli utenti segnalano il blocco anche di modifiche minori (come il cambio dei pantaloni in pantaloncini).

Dal mio punto di vista, questo accade perché Sora 2 è molto prudente, soprattutto dopo che nel 2025 alcuni utenti minorenni sono stati sorpresi a bypassare i filtri usando una terminologia medica per richiedere contenuti NSFW.

3. Scansione post-generazione fotogramma per fotogramma

Una volta generato il video, questo non va subito in onda. Sora 2 esegue moderazione video a livello di frame, analizzando ogni fotogramma alla ricerca di violazioni nascoste della politica, come simboli di odio, immagini esplicite o immagini manipolate.

Secondo OpenAI, questa scansione finale rimuove 95-99% di video problematici prima che gli utenti li scarichino. Se da un lato questo è ottimo per la sicurezza, dall'altro significa che alcuni contenuti creativi legittimi, come le rievocazioni storiche o la body art, finiscono nel fuoco incrociato.

Come Sora 2 gestisce i casi più difficili di moderazione

Non tutti i messaggi di blocco sono uguali. Sora 2 utilizza set di regole specializzate per le categorie ad alto rischio che in passato hanno causato reazioni da parte dell'opinione pubblica, in particolare la generazione di ritratti, la protezione della proprietà intellettuale e la sicurezza dei minorenni.

1. Ritratto e protezione IP

Dopo le ripetute controversie del 2024, come la generazione da parte degli utenti di sembianze non autorizzate di attori reali o personaggi di anime, OpenAI ha lanciato un programma di “Sistema ”opt-in per qualsiasi figura riconoscibile.

Ora, non si può generare una celebrità o un personaggio di fantasia a meno che il proprietario dell'IP non lo approvi esplicitamente. Ad esempio, la generazione di “James Bond” o “Mario” comporta un blocco immediato.

Per le immagini personali, Sora 2 richiede un consenso esplicito. È possibile caricare una propria foto e permettere al modello di utilizzarla, ma non è possibile creare video di altre persone senza la loro approvazione. OpenAI ha anche aggiunto un “Trova e rimuovi la mia immagine” che consente di cercare ed eliminare i video che contengono la propria immagine, cosa che ho provato io stesso quando il mio volto è apparso in un video di remix senza il mio consenso.

2. Trasparenza per i contenuti generati dall'intelligenza artificiale

Ogni video prodotto da Sora 2 è ora dotato di entrambe le caratteristiche filigrane visibili e invisibili. È presente una filigrana dinamica sullo schermo per gli spettatori, oltre a metadati nascosti incorporati nel file.

Ciò consente alle piattaforme e agli editori di verificare i contenuti di origine AI utilizzando gli strumenti di rilevamento ufficiali di OpenAI, fondamentali per contrastare i deepfake e la disinformazione, dato che i video AI diventano sempre più iperrealistici.

3. Protezione dei minori

Sora 2 è intransigente quando si tratta di minori. Blocca qualsiasi richiesta che possa essere utilizzata per generare o raffigurare bambini in contesti non sicuri. I filtri del sistema si applicano sia a livello di testo che di scansione visiva, assicurando che non compaiano minorenni in scenari inappropriati.

Questo approccio è in linea con leggi globali come COPPA negli Stati Uniti e di quadri equivalenti nell'UE e in Asia.

Quando la moderazione incontra la creatività: La lotta degli utenti reali

Nonostante la chiara logica alla base di questi sistemi, la moderazione ha scatenato la frustrazione dei creatori. Molti, compreso il sottoscritto, hanno trovato Sora 2 troppo restrittivo per progetti creativi legittimi.

Sul forum degli sviluppatori di OpenAI, gli utenti hanno riferito di essere stati segnalati per modifiche innocue come “cambiare acconciatura” o “scambiare gli abiti”, e un creatore ha descritto di essere stato bloccato dopo aver tentato di spostare lo sfondo di una foto da una strada cittadina a una spiaggia.

Mi sono imbattuto nello stesso problema: anche contenuti didattici o artistici-come le sculture classiche o gli studi sul movimento della danza, possono essere erroneamente segnalati come non sicuri. Sebbene ciò possa sembrare eccessivamente prudente, OpenAI ha dichiarato che “i falsi positivi sono preferibili ai potenziali danni”.”

A suo merito, OpenAI ha risposto introducendo un sistema di “strato di ”comprensione contestuale, che cerca di distinguere tra espressione artistica e contenuti dannosi. Ad esempio, un messaggio che descrive un evento storico violento a scopo educativo ha ora maggiori probabilità di passare la moderazione rispetto a prima.

La repressione del copyright e il coinvolgimento delle AMP

In Ottobre 2025, La Motion Picture Association (MPA) ha accusato Sora 2 di “violazione sistemica del copyright,”, citando clip generate dagli utenti che imitano scene di film. In risposta, OpenAI ha accelerato gli aggiornamenti dei suoi strumenti di proprietà intellettuale, consentendo ai titolari dei diritti d'autore di definire politiche d'uso sfumate, come ad esempio consentire l'uso dei loro personaggi in contesti “familiari” ma non in quelli violenti o satirici.

Dai miei test, questa modifica ha ridotto sensibilmente le richieste di blocco per parodie sicure o tributi dei fan, che in precedenza facevano scattare divieti totali. È un segno positivo che OpenAI stia iniziando a bilanciare la protezione con la libertà creativa.

Moderazione nelle API degli sviluppatori

Se si utilizza Sora 2 attraverso il programma API, la moderazione non è facoltativa. Ogni chiamata API, in particolare creare_video-Esegue controlli automatici di conformità. L'output finale non può essere recuperato finché il video non supera la revisione di moderazione.

Per gli sviluppatori che costruiscono applicazioni su Sora 2, questo significa meno rischi legali e contenuti più sicuri per gli utenti, ma anche tempi di realizzazione più lenti. Si tratta di un compromesso tra conformità e velocità.

Cosa c'è di nuovo per il sistema di moderazione di Sora 2

Il Il mercato dei video AI dovrebbe raggiungere $18,6 miliardi entro la fine del 2025, e il sistema di moderazione di Sora 2 è già considerato un punto di riferimento per il settore.

OpenAI prevede di ampliare le partnership con i proprietari dei diritti d'autore, di migliorare la conformità regionale (soprattutto in Giappone e nell'UE) e di perfezionare il rilevamento contestuale per ridurre i falsi segnalatori. Per i creatori, questo significa un ambiente più sicuro ma ancora in evoluzione, in cui dovremo continuare ad adattare i nostri stili di richiesta e la nostra formulazione per rimanere entro le linee.

Riflessioni finali: Bilanciare creatività e responsabilità

Dopo mesi di utilizzo quotidiano di Sora 2, ho capito che il suo sistema di moderazione non serve a limitare la creatività, ma a proteggerla dal futuro. Certo, può essere frustrante quando vengono bloccate richieste innocenti. Ma considerando l'entità dell'uso improprio che gli strumenti video dell'intelligenza artificiale potrebbero fare, il compromesso è comprensibile.

Sora 2 mostra che Creatività e sicurezza dell'intelligenza artificiale possono coesistere-Ma sta a noi creatori imparare a navigare nella logica del sistema. Comprendendo come funziona la moderazione e adattando le nostre frasi e i nostri riferimenti, possiamo ottenere risultati più espressivi, conformi e globalmente accettabili.