Pourquoi Sora 2 bloque vos messages (La vraie raison)

Depuis le début de l'année 2025, Création de vidéos à l'aide de l'IA a explosé pour atteindre plus de 320 millions d'utilisateurs consommateurs dans le monde, L'OpenAI a fait de la sécurité et de la conformité l'épine dorsale de la conception de Sora 2. Cela signifie que certaines invites qui fonctionnaient dans Sora 1 ou dans d'autres modèles sont désormais instantanément bloquées, non pas parce que vous avez fait quelque chose de mal, mais parce que le nouveau système est intentionnellement conservateur pour éviter les abus.

En bref : vos messages sont bloqués parce que Sora 2 effectue des contrôles de sécurité à trois niveaux-avant, pendant et après la génération, afin de détecter les risques liés à l'utilisation abusive de la propriété intellectuelle, au contenu explicite ou aux violations de la vie privée. Si vous souhaitez contourner les restrictions de contenu, Voici un guide.

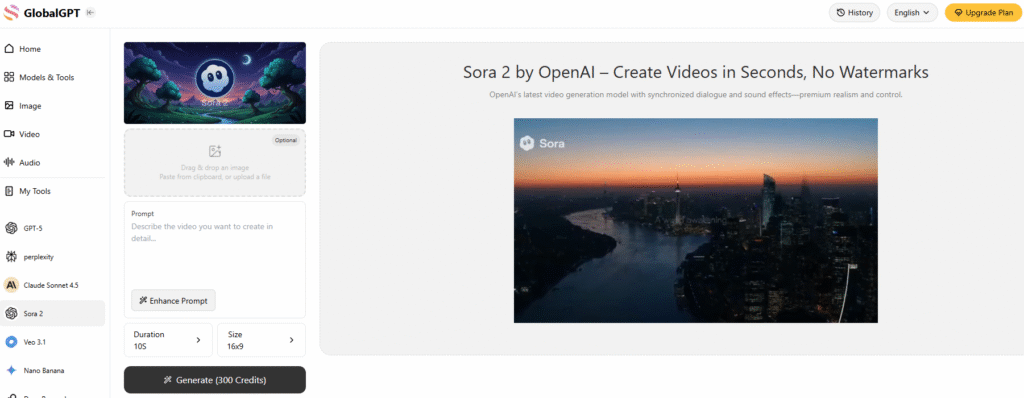

L'un des moyens les plus efficaces de contourner les restrictions de contenu de Sora 2 consiste à utiliser une plateforme d'IA tout-en-un qui intègre Sora 2 - Ainsi, vous serez confronté à beaucoup moins de restrictions en matière de contenu et à moins d'obstacles à l'accès à l'Internet. pas de problème de filigrane. Mieux encore, ces plates-formes Sora 2 tierces n'ont pas nécessitent ces codes d'invitation gênants soit.

Global maintenant aussi intègre Veo 3.1, Le système de gestion de l'information de la Commission européenne vous permet d'accéder aux deux modèles de génération vidéo les plus puissants, ainsi qu'au système de gestion de l'information de la Commission européenne. 10+ autres modèles vidéo simultanément sur Global GPT.

L'architecture de modération à trois niveaux

La modération de Sora 2 est construite comme un pare-feu autour de la créativité. OpenAI parle d'un modèle de ’prévention d'abord“, ce qui signifie que le système filtre les violations potentielles à un stade précoce au lieu de les corriger plus tard. Voici comment fonctionne chaque couche :

1. Analyse au niveau de l'invite

Avant même que la génération ne commence, Sora 2 analyse votre saisie de texte à la recherche de termes sensibles ou susceptibles d'enfreindre la politique. Cela comprend les cas évidents (contenu adulte ou violent), mais aussi les risques subtils tels que “ressemblance avec une célébrité”, “scénarios politiques” ou “violence militaire réaliste”.”

Par exemple, lorsque j'ai essayé de créer un clip de style court-métrage inspiré de une bataille historique, Sora 2 a rejeté l'invitation, la qualifiant de “potentiellement violente”. Après l'avoir modifié pour qu'il se concentre sur la “narration héroïque” plutôt que sur la “représentation d'une bataille”, il a finalement été accepté. Cette expérience m'a appris à quel point le filtre linguistique de Sora 2 est précis : parfois, un seul mot change tout.

2. Révision du téléchargement des médias

Si vous téléchargez des images ou des clips de référence, le système de Sora 2 effectue une reconnaissance optique de caractères (OCR) et des vérifications visuelles pour détecter les éléments interdits ou protégés par le droit d'auteur. Il recherche des logos, des visages de célébrités ou des détails privés.

J'ai testé cela une fois en téléchargeant un selfie et en demandant à Sora 2 de “changer la tenue pour une scène de plage”. À ma grande surprise, la photo a été signalée comme “contenu inapproprié”. Ce type de faux positif a souvent été évoqué sur le forum communautaire d'OpenAI, où les utilisateurs signalent que même des modifications mineures (comme le remplacement d'un pantalon par un short) ont été bloquées.

De mon point de vue, cela s'explique par le fait que Sora 2 fait preuve d'une grande prudence, surtout après que des utilisateurs mineurs ont été surpris en train de contourner les filtres en 2025 en utilisant une terminologie médicale pour demander du contenu NSFW.

3. Analyse post-générationnelle image par image

Une fois que votre vidéo est générée, elle n'est pas immédiatement mise en ligne. Sora 2 se produit modération vidéo au niveau de l'image, Il s'agit d'analyser chaque image pour y déceler des violations cachées de la politique, telles que des symboles de haine, des images explicites ou des ressemblances manipulées.

Selon OpenAI, cette dernière analyse permet de supprimer 95-99% des vidéos problématiques avant que les utilisateurs ne les téléchargent. C'est une bonne chose pour la sécurité, mais cela signifie aussi que certains contenus créatifs légitimes, comme les reconstitutions historiques ou l'art corporel, sont pris entre deux feux.

Comment Sora 2 gère les cas de modération les plus difficiles

Tous les messages bloqués ne sont pas égaux. Sora 2 utilise des ensembles de règles spécialisées pour les catégories à haut risque qui ont suscité des réactions négatives de la part du public dans le passé, en particulier la production de portraits, la protection de la propriété intellectuelle et la sécurité des mineurs.

1. Portrait et protection IP

Après des controverses répétées en 2024 - comme des utilisateurs générant des ressemblances non autorisées avec des acteurs réels ou des personnages d'anime - OpenAI a mis en place un programme d'aide à la création d'entreprise. “Système ”opt-in pour toute figure reconnaissable.

Aujourd'hui, vous ne pouvez pas générer une célébrité ou un personnage de fiction à moins que le détenteur de la propriété intellectuelle ne l'approuve explicitement. Par exemple, la création de “James Bond” ou de “Mario” entraînera un blocage immédiat.

Pour les images personnelles, Sora 2 exige un consentement explicite. Vous pouvez télécharger votre propre photo et autoriser le modèle à l'utiliser, mais vous ne pouvez pas créer de vidéos d'autres personnes sans leur accord. OpenAI a également ajouté un “Trouver et supprimer mon image” qui vous permet de rechercher et de supprimer les vidéos contenant votre image - ce que j'ai moi-même testé lorsque mon visage est apparu dans une vidéo remixée sans mon consentement.

2. Transparence du contenu généré par l'IA

Chaque vidéo produite par Sora 2 comporte désormais les deux éléments suivants filigranes visibles et invisibles. Il y a un filigrane dynamique à l'écran pour les téléspectateurs, ainsi que des métadonnées cachées dans le fichier.

Cela permet aux plateformes et aux éditeurs de vérifier le contenu provenant de l'IA à l'aide des outils de détection officiels d'OpenAI, ce qui est essentiel pour contrer les deepfakes et la désinformation à mesure que les vidéos d'IA deviennent hyperréalistes.

3. Protection des mineurs

Sora 2 est intransigeant en ce qui concerne les mineurs. Il bloque toute invite qui pourrait être utilisée pour générer ou représenter des enfants dans des contextes dangereux. Les filtres du système s'appliquent à la fois au niveau du texte et au niveau de l'analyse visuelle, ce qui garantit qu'aucun mineur n'apparaît dans des scénarios inappropriés.

Cette approche s'aligne sur les lois mondiales telles que COPPA aux États-Unis et des cadres équivalents dans l'UE et en Asie.

Quand la modération rencontre la créativité : La lutte des utilisateurs réels

Malgré la logique claire qui sous-tend ces systèmes, la modération a suscité la frustration des créateurs. Nombreux sont ceux, dont je fais partie, qui ont trouvé que Sora 2 trop restrictif pour des projets créatifs légitimes.

Sur le forum des développeurs de l'OpenAI, des utilisateurs ont indiqué avoir été signalés pour des modifications anodines telles que “changer de coiffure” ou “échanger des tenues”, et un créateur a raconté avoir été bloqué après avoir tenté de déplacer l'arrière-plan d'une photo d'une rue de la ville à une plage.

J'ai rencontré le même problème : même les le contenu éducatif ou artistique-comme les sculptures classiques ou les études sur les mouvements de danse - peuvent être signalés à tort comme dangereux. Bien que cela puisse sembler trop prudent, OpenAI a déclaré que “les faux positifs sont préférables aux dommages potentiels”.”

À son crédit, OpenAI a réagi en introduisant un système de gestion de l'information. “Couche ”compréhension contextuelle, qui tente de faire la distinction entre l'expression artistique et le contenu préjudiciable. Par exemple, un message décrivant un événement historique violent à des fins éducatives a désormais plus de chances de passer la modération qu'auparavant.

La répression des droits d'auteur et l'implication des AMP

En Octobre 2025, La Motion Picture Association (MPA) a accusé Sora 2 de “ [...]“violation systémique des droits d'auteur,en citant des clips générés par les utilisateurs et imitant des scènes de films. En réponse, l'OpenAI a accéléré la mise à jour de ses outils de propriété intellectuelle, permettant aux détenteurs de droits d'auteur de définir des politiques d'utilisation nuancées, par exemple en autorisant leurs personnages dans des contextes ”familiaux“, mais pas dans des contextes violents ou satiriques.

D'après mes propres tests, ce changement a sensiblement réduit le nombre d'invites bloquées pour les parodies ou les hommages de fans, qui déclenchaient auparavant des interdictions totales. C'est un signe encourageant qu'OpenAI commence à trouver un équilibre entre la protection et la liberté de création.

Modération dans les API des développeurs

Si vous utilisez Sora 2 par l'intermédiaire de l'application API, la modération n'est pas facultative. Chaque appel à l'API - en particulier créer_vidéo-exécute des contrôles de conformité automatiques. La sortie finale ne peut pas être récupérée tant que la vidéo n'a pas fait l'objet d'un contrôle de modération.

Pour les développeurs qui créent des applications à partir de Sora 2, cela signifie moins de risques juridiques et un contenu utilisateur plus sûr par défaut, mais aussi des délais d'exécution plus longs. Il s'agit d'un compromis entre conformité et rapidité.

Prochaines étapes du système de modération de Sora 2

Le Le marché de l'IA vidéo devrait atteindre $18,6 milliards d'euros fin 2025., Le système de modération de Sora 2 est déjà considéré comme une référence dans l'industrie.

L'OpenAI prévoit d'étendre ses partenariats avec les détenteurs de droits d'auteur, d'améliorer la conformité régionale (en particulier au Japon et dans l'UE) et d'affiner la détection contextuelle pour réduire le nombre de fausses alertes. Pour les créateurs, cela signifie un environnement plus sûr mais toujours en évolution, dans lequel nous devrons continuer à adapter nos styles et nos formulations pour rester dans les clous.

Dernières réflexions : Concilier créativité et responsabilité

Après des mois d'utilisation quotidienne de Sora 2, j'ai réalisé que son système de modération n'est pas là pour limiter la créativité, mais pour la protéger. Oui, il peut être frustrant de voir des messages innocents bloqués. Mais compte tenu de l'ampleur des abus auxquels les outils vidéo d'IA pourraient être confrontés, le compromis est compréhensible.

Sora 2 montre que La créativité et la sécurité de l'IA peuvent coexister-Mais c'est à nous, créateurs, d'apprendre à naviguer dans la logique du système. En comprenant le fonctionnement de la modération et en ajustant nos formulations et nos références, nous pouvons obtenir des résultats plus expressifs, plus conformes et plus acceptables au niveau mondial.