Por qué Sora 2 bloquea tus prompts (La verdadera razón)

Desde principios de 2025, Creación de vídeos con IA se ha disparado a más de 320 millones de usuarios en todo el mundo, y OpenAI ha hecho de la seguridad y la conformidad la columna vertebral del diseño de Sora 2. Esto significa que algunas indicaciones que funcionaban en Sora 1 u otros modelos ahora se bloquean instantáneamente. Eso significa que algunas indicaciones que solían funcionar en Sora 1 u otros modelos ahora se bloquean instantáneamente, no porque hayas hecho algo mal, sino porque el nuevo sistema es intencionadamente conservador para evitar el mal uso.

Resumiendo: tus indicaciones están bloqueadas porque Sora 2 ejecuta comprobaciones de seguridad de triple capa-antes, durante y después de la generación- para detectar riesgos de uso indebido de la propiedad intelectual, material explícito o violaciones de la privacidad. Si desea eludir las restricciones de contenido, Aquí tiene una guía.

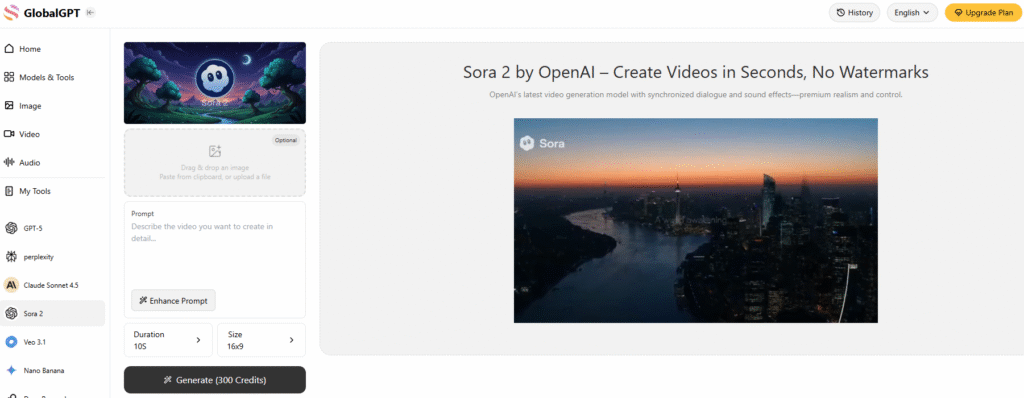

Una de las formas más eficaces de eludir las restricciones de contenido de Sora 2 es utilizar una plataforma de IA todo en uno que integre Sora 2 - de esta forma, se enfrentará a muchas menos restricciones de contenido y sin marcas de agua. Mejor aún, estas plataformas Sora 2 de terceros no requieren esos molestos códigos de invitación tampoco.

Global ahora también integra Veo 3.1, lo que le permite acceder a los dos modelos más potentes de generación de vídeo junto con Más de 10 modelos de vídeo simultáneamente en Global GPT.

Arquitectura de moderación en tres niveles

La moderación de Sora 2 se construye como un cortafuegos en torno a la creatividad. OpenAI lo denomina un modelo de ’prevención en primer lugar“, lo que significa que el sistema filtra las posibles infracciones en una fase temprana en lugar de corregirlas más tarde. Así funciona cada capa:

1. Exploración a nivel de solicitud

Antes incluso de que empiece la generación, Sora 2 analiza el texto introducido en busca de términos sensibles o que infrinjan la política. Esto incluye casos obvios -contenido para adultos o violento-, pero también riesgos sutiles como “parecido con famosos”, “escenarios políticos” o “violencia militar realista”.”

Por ejemplo, cuando una vez intenté crear un clip estilo cortometraje inspirado en una batalla histórica, Sora 2 rechazó la propuesta por considerarla “potencialmente violenta”. Después de modificarlo para que se centrara en la “narración heroica” en lugar de en la “representación de batallas”, finalmente fue aprobado. Esa experiencia me enseñó lo específico que es el filtro lingüístico de Sora 2: a veces, una sola palabra lo cambia todo.

2. Revisión de la carga de medios

Si subes imágenes o clips de referencia, el sistema de Sora 2 ejecuta un OCR (reconocimiento óptico de caracteres) y comprueba visualmente si hay material prohibido o protegido por derechos de autor. Busca logotipos, caras de famosos o detalles privados.

Probé esto una vez subiendo un selfie y pidiendo a Sora 2 que “cambiara el atuendo a una escena de playa”. Sorprendentemente fue marcado como “contenido inapropiado”. Este tipo de falsos positivos ha sido un tema frecuente en el foro de la comunidad de OpenAI, donde los usuarios informan de que incluso ediciones menores (como cambiar los pantalones por pantalones cortos) son bloqueadas.

Desde mi punto de vista, esto se debe a que Sora 2 peca mucho de precavido, sobre todo después de que se descubriera a usuarios menores de edad saltándose los filtros en 2025 utilizando terminología médica para solicitar contenido NSFW.

3. Escaneado fotograma a fotograma postgeneración

Una vez generado el vídeo, no se emite inmediatamente. Sora 2 realiza moderación de vídeo por fotogramas, analizando cada fotograma en busca de infracciones ocultas de la política, como símbolos de odio, imágenes explícitas o imágenes manipuladas.

Según OpenAI, este escaneo final elimina 95-99% de vídeos problemáticos antes de que los usuarios lleguen a descargarlos. Aunque esto es bueno para la seguridad, también significa que algunos contenidos creativos legítimos, como recreaciones históricas o arte corporal, quedan atrapados en el fuego cruzado.

Cómo gestiona Sora 2 los casos de moderación más difíciles

No todos los avisos bloqueados son iguales. Sora 2 utiliza conjuntos de normas especializadas para categorías de alto riesgo que han provocado reacciones públicas en el pasado, especialmente la generación de retratos, la protección de la propiedad intelectual y la seguridad de los menores.

1. Retrato y protección IP

Tras repetidas polémicas en 2024 -como usuarios que generaban semejanzas no autorizadas de actores reales o personajes de anime- OpenAI puso en marcha una “sistema ”opt-in para cualquier figura reconocible.

Ahora, no puedes generar una celebridad o personaje de ficción a menos que el propietario de la IP lo apruebe explícitamente. Por ejemplo, generar “James Bond” o “Mario” provocará un bloqueo instantáneo.

Para los retratos de personas, Sora 2 requiere el consentimiento explícito. Puedes subir tu propia foto y permitir que el modelo la utilice, pero no puedes crear vídeos de otras personas sin su aprobación. OpenAI también ha añadido un “Encontrar y eliminar mi semejanza” que te permite buscar y eliminar vídeos que contengan tu imagen, algo que yo mismo probé cuando mi cara apareció en un vídeo de remezcla sin mi consentimiento.

2. Transparencia de los contenidos generados por IA

Todos los vídeos producidos por Sora 2 llevan ahora ambos marcas de agua visibles e invisibles. Hay una marca de agua dinámica en pantalla para los espectadores, además de metadatos ocultos incrustados en el archivo.

Esto hace posible que las plataformas y los editores verifiquen el contenido originado por IA utilizando las herramientas de detección oficiales de OpenAI, algo fundamental para contrarrestar las falsificaciones y la desinformación a medida que los vídeos de IA se vuelven hiperrealistas.

3. Protección de menores

Sora 2 es inflexible cuando se trata de menores. Bloquea cualquier indicación que pudiera utilizarse para generar o representar a niños en contextos inseguros. Los filtros del sistema se aplican tanto a nivel de texto como en la exploración visual, lo que garantiza que no aparezcan menores de edad en escenarios inapropiados.

Este planteamiento se ajusta a leyes mundiales como COPPA en Estados Unidos y marcos equivalentes en la UE y Asia.

Cuando la moderación se une a la creatividad: La verdadera lucha de los usuarios

A pesar de la clara lógica de estos sistemas, la moderación ha provocado frustración entre los creadores. Muchos -entre los que me incluyo- han considerado que Sora 2 demasiado restrictivo para proyectos creativos legítimos.

En el foro de desarrolladores de OpenAI, los usuarios informaron de que se les había marcado por ediciones inofensivas como “cambiar de peinado” o “cambiar de ropa”, y un creador describió que se le había bloqueado tras intentar cambiar el fondo de una foto de una calle urbana a una playa.

Me he encontrado con el mismo problema: incluso contenido educativo o artístico-como las esculturas clásicas o los estudios de movimientos de danza- pueden ser marcados incorrectamente como inseguros. Aunque esto pueda parecer excesivamente cauteloso, OpenAI ha declarado que “los falsos positivos son preferibles a un daño potencial”.”

OpenAI ha respondido con la introducción de una “capa ”comprensión contextual, que intenta distinguir entre expresión artística y contenido nocivo. Por ejemplo, un mensaje que describa un acontecimiento histórico violento con fines educativos tiene ahora más probabilidades de pasar la moderación que antes.

La represión de los derechos de autor y la participación de las AMP

En Octubre de 2025, la Motion Picture Association (MPA) acusó a Sora 2 de “infracción sistémica de los derechos de autor,citando clips generados por los usuarios que imitan escenas de películas. En respuesta, OpenAI aceleró las actualizaciones de sus herramientas de propiedad intelectual, permitiendo a los titulares de derechos de autor definir políticas de uso matizadas, como permitir sus personajes en contextos ”familiares“ pero no en contextos violentos o satíricos.

Según mis propias pruebas, este cambio ha reducido notablemente las solicitudes bloqueadas de parodias seguras u homenajes de fans, que antes provocaban prohibiciones totales. Es una buena señal de que OpenAI está empezando a equilibrar la protección con la libertad creativa.

Moderación en las API para desarrolladores

Si utilizas Sora 2 a través de la aplicación API, la moderación no es opcional. Cada llamada a la API, especialmente crear_vídeo-ejecuta comprobaciones automáticas de conformidad. El resultado final no puede recuperarse hasta que el vídeo pase la revisión de moderación.

Para los desarrolladores que crean aplicaciones sobre Sora 2, esto significa menos riesgos legales y contenidos de usuario más seguros por defecto, pero también plazos de entrega más lentos. Es un compromiso entre cumplimiento y velocidad.

Próximas novedades del sistema de moderación de Sora 2

En Se prevé que el mercado del vídeo con IA alcance los $18.600 millones a finales de 2025, y el sistema de moderación de Sora 2 ya se considera una referencia en el sector.

OpenAI tiene previsto ampliar las asociaciones con los propietarios de derechos de autor, mejorar el cumplimiento regional (especialmente en Japón y la UE) y perfeccionar la detección contextual para reducir las falsas alarmas. Para los creadores, esto significa un entorno más seguro, pero aún en evolución, en el que tendremos que seguir adaptando nuestros estilos de aviso y la redacción para mantenernos dentro de las líneas.

Reflexiones finales: Equilibrio entre creatividad y responsabilidad

Tras meses de uso diario de Sora 2, me he dado cuenta de que su sistema de moderación no está ahí para limitar la creatividad, sino para protegerla del futuro. Sí, puede ser frustrante cuando se bloquean mensajes inocentes. Pero teniendo en cuenta la magnitud del uso indebido que pueden sufrir las herramientas de vídeo con IA, la compensación es comprensible.

Sora 2 demuestra que La creatividad y la seguridad de la IA pueden coexistir-Pero depende de nosotros, los creadores, aprender a navegar por la lógica del sistema. Si entendemos cómo funciona la moderación y ajustamos nuestras frases y referencias, podremos obtener resultados más expresivos, conformes y aceptables para todo el mundo.